![]()

INFORMATICA - L'HARDWARE DEL PERSONAL COMPUTER

I PERSONAL COMPUTER

I personal computer, grazie anche alla continua diminuzione dei costi, sono ormai estremamente diffusi, sia per utilizzo professionale che privato. I personal computer più utilizzati sono i Personal IBM e gli IBM compatibili; con questi ultimi si intendono i PC che, pur essendo prodotti da diverse società, funzionano allo stesso modo dei personal IBM. Essi adottano il sistema operativo MS-DOS e l'ambiente Windows della Microsoft. Un'altra famiglia di personal è quella della Apple, che utilizza un sistema operativo proprietario, ma che sempre più è compatibile con Dos e Windows.L'UNITA' DI SISTEMA

Il computer è formato da un'unità di sistema a cui sono collegati la tastiera, il video e altre periferiche, come la stampante, il mouse ecc. L'unità di sistema è una cassa metallica che può avere forme differenti; ci sono versioni da tavolo (desktop), a torre (tower) e i laptop (che hanno inglobate tastiera e schermo); i modelli più diffusi attualmente sono i desktop. La cassa è formata da un'intelaiatura e da un involucro che si può togliere; sul davanti ci sono le aperture dei driver per i floppy disk; per i modelli desktop l'interruttore per l'accensione, di solito, è sul retro a destra. La cassa contiene la scheda di sistema, un alimentatore, le schede adattatrici, alcune periferiche interne come l'unità a disco, il drive per i floppy e per i nastri, con il dispositivo di controllo delle unità disco, ecc.L'ALIMENTATORE

L'alimentatore converte la corrente alternata in corrente continua per il funzionamento della scheda di sistema; contiene di solito una ventola per il raffreddamento dell'unità alcuni cavi intrecciati e colorati che fuoriescono da una parte; una presa tripolare di ingresso e un tasto di accensione. L'alimentatore eroga una serie di tensioni e amperaggi diversi (vari sono i cavi di uscita che si connettono alla motherboard e ai vari dispositivi interni al computer) secondo il modello e la potenza scelta (300-800 Watt). È ovvio che più dispositivi sono montati nel PC maggiore è la potenza richiesta. Su certi server vengono perfino montati 2 alimentatori separati al fine di garantire il funzionamento (parziale) della macchina nel caso che uno si guasti. L'alimentatore è dotato anche di circuito di protezione da "Spike di rete" ossia variazioni improvvise o sovratensioni sulla rete elettrica.Due sono i modelli presenti sul mercato:

- AT, ormai non più prodotto perché utilizzato sui vecchi modelli di PC serie 286,386 e 486;

- ATX, attualmente prodotto;

- BTX, previsto in futuro.

La soluzione attualmente in commercio differisce a prima vista proprio per la spina del cavo della presa di connessione alla motherboard e per la modalità di accensione e spegnimento dell'alimentatore (non esiste più l'interruttore a filo): la soluzione tecnologica adottata associa una maggiore semplicità/rapidità di montaggio oltre che una tensione elettrica inferiore: in poche parole, i processori e le schede madri odierne, a parità di prestazioni, assorbono meno corrente rispetto a quelle delle generazioni precedenti. Negli ultimi anni, molte case produttrici hanno realizzato alimentatori con una sorta di Intelligenza artificiale integrata: tali alimentatori sono tipicamente in grado:

- di capire se il sistema connesso è correttamente connesso a livello elettrico, prima di iniziare l'erogazione della corrente (così da evitare rotture dovute a corto circuito);

- di capire se il carico connesso è eccessivo, così da evitare surriscaldamenti o l'insorgere di piccoli incendi ;

- di mantenere, all'atto dello spegnimento del sistema in uso, la ventola accesa così da favorire la dispersione verso l'esterno dell'energia termina residua all'interno del case;

- di variare la velocità della ventola (o delle ventole) in funzione dell'assorbimento, così da minimizzare i rumori al minimo indispensabile.

LA SCHEDA DI SISTEMA O MOTHERBOARD

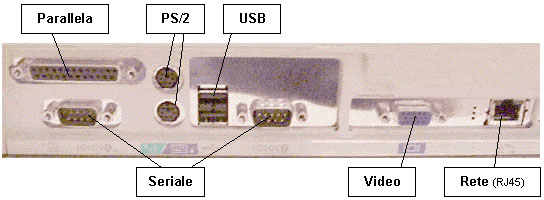

Con essa si intende la scheda del circuito principale del computer; a prima vista sulla motherboard (scheda madre) sono alloggiati i vari chip e altri componenti elettronici. Sulla scheda di sistema sono innestati: - il microprocessore (CPU), collegato agli altri elementi della piastra madre tramite conduttori stampati sulla piastra stessa; - le memorie (RAM e ROM); - il BUS per il trasferimento dei dati; - una serie di connettori (chiamati slitte di inserimento delle espansioni o slot di espansione) per collegare le schede adattatrici; - alcune schede o controller, che possono far parte già della scheda di sistema invece di occupare degli slot. Sul retro della scheda madre c'è una lastra con le porte di comunicazione per collegare dispositivi periferici: ci sono porte parallele (che permettono di trattare un byte alla volta) e porte seriali (che gestiscono la comunicazione in bit). Guardando più nel dettaglio si possono vedere una serie miniaturizzata di circuiti (piste) fuse insieme alla plastica superficiale della motherboard (da entrambi i lati), interrotti qua e là da circuiti integrati, zoccoli, slot, connettori, processori vari ed il chip del bios.In particolare si può osservare un gruppo abbastanza denso e voluminoso di linee parallele che attraversano parte della scheda, dalla zona ove sono presenti gli alloggiamenti delle memorie, alla zona sottostante al processore, fino agli slot: questo è il bus. In posizioni predefinite inoltre sono presenti alcuni fori circolari, utilizzati per fissare solidamente la scheda al case metallico del computer mediante viti passanti isolate o tasselli in plastica. Le motherboard non sono tutte uguali, differiscono per produttore e modello, per tipo di processore/chipset supportato e per tipi di memorie (ed anche capacità) installabili, oltre che per periferiche già preinstallate (processore video ed audio, connettività di rete, porta infrarossi, porte USB, controller SCSI e RAID per esempio). Molte di queste caratteristiche determinano in genere un aumento di prezzo rispetto alla versione base. Nell'ultimo decennio i maggiori produttori mondiali hanno ricercato sempre più la compattezza, la semplicità di installazione e la riduzione delle parti mobili presenti sulle motherboard. Dai primi modelli AT, su cui era necessario fissare una serie di accessori dopo aver stabilmente avvitato la motherboard sul case, si è passati al modello ATX, ben più ergonomico ed "essenziale": i costruttori dei case metallici hanno variato la forma e geometria dello (chassis), quelli degli alimentatori le tensioni/amperaggi sui cavi verso la motherboard. Nel modello ATX tutte le porte, gli accessori e le uscite sono presenti solidalmente su di un lato della scheda. Lo svantaggio è che nella maggior parte dei casi di guasto è necessario sempre sostituire l'intera scheda madre. Le impostazioni necessarie a garantire il corretto settaggio della tensione di core e della velocità di clock della CPU sono, sui modelli ATX, configurabili dal BIOS della scheda madre seguendo le istruzioni riportate sul manuale del costruttore. Precedentemente e su alcune motherboard economiche ad oggi commercializzate, si doveva operare con i ponticelli, piccoli archi metallici da unire a contatti elettrici disposti sulla scheda madre per definirne il comportamento. Tale soluzione si rivelava molto scomoda nel caso fosse necessario variare spesso la configurazione hardware di sistema. Talvolta, il moltiplicatore di frequenza delle CPU è bloccato via hardware dal costruttore per impedire che tali componenti possano essere overcloccate.

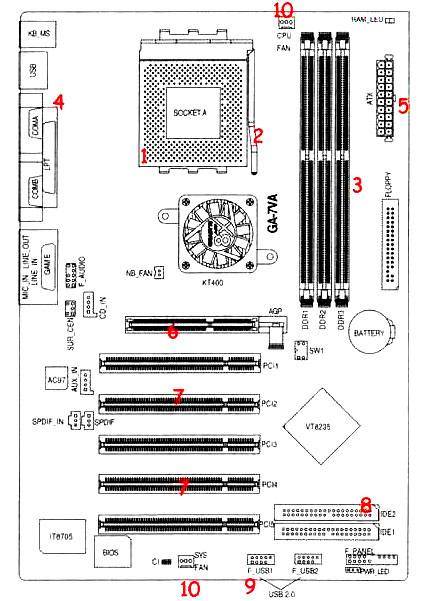

Attraverso uno schema sintetico è possibile riconoscere le parti fondamentali della scheda madre:

il Socket (1) è l'alloggiamento del processore, presenta una serie di forellini in cui trovano alloggiamento gli altrettanti piedini del processore. Come si nota, mancano i fori negli angoli in alto a destra e sinistra, in questo modo non si può sbagliare verso quando si colloca il processore. Sulla destra del Socket c'è una levetta (2): tenetela sollevata quando mettete il processore in sede (basta appoggiarlo), quindi abbassatela per bloccarlo in sede. Se il processore ha qualche piedino storto, cercate con la massima delicatezza di raddrizzarlo con una pinzetta senza forzarne la entrata nel Socket. A seconda del Socket presente sulla scheda madre, potrete inserivi un processore ma sempre attendendovi a ciò che è definito nel manuale del produttore. Sotto al Socket (1) si può vedere il chipset, sistema che fornisce una serie di servizi importanti a supporto del processore: con esso dipende anche la quantità di Ram totale gestibile dalla scheda madre, la frequenza massima della Ram (vedi parte sulla Ram) e la massima frequenza del processore che si può installare. A destra (3) ci sono gli alloggiamenti per le schede di memoria Ram, le schede vanno inserite a partire dallo slot contrassegnato sulla scheda madre con DDR1 in questo caso. In (4) invece si trovano i connettori (che sporgeranno sul retro del PC) delle porte ps2 (quei due connettori tondi viola e verde, che sono rispettivamente per la tastiera e per il mouse), le porte seriali e parallele, le porte USB e i tre jack audio rosa verde e azzurro che sono presenti se la scheda audio è integrata nella scheda madre (come oramai in tutte quante oggi). In (5) invece c'è il connettore su cui va attaccato il cavo di alimentazione, che arriva dall'alimentatore: anche questo connettore ha solo un verso di inserimento, quindi non ci si sbaglia nel montaggio. In (6) c'è lo slot AGP 8x in cui va inserita la scheda video (può essere una scheda video anche AGP 4x, ma non vale il contrario): da notare sulla destra dello slot una specie di pulsantino, che va tirato verso l'esterno quando si inserisce la scheda e poi rilasciato per bloccarla in sede. Lo slot ha un taglio che fa in modo che la scheda si possa inserire solo in un modo. La scheda dovrebbe entrare senza incontrare eccessive resistenze, in ogni caso spingere sempre con delicatezza. Il nuovo standard di slot per schede video, che sostituirà presto anche gli altri slot PCI, è il PCI Express. In (7) gli slot PCI, in cui potete inserire eventuali modem interno, schede di rete, schede sonore, schede tv, ecc. In (8) ci sono i due connettori EIDE: IDE1 e IDE2, detti rispettivamente Primary e Secondary, che presentano due file di spuntoncini. Su essi vanno inseriti gli appositi cavi EIDE (cavi grigi) che vanno alle periferiche CD e hard disk. Inoltre a destra degli slot per le schede di memoria, sopra la pila tonda (battery, che serve per l'orologio del computer) si trova l'analogo connettore per il floppy. Il computer si può avviare anche se manca uno dei cavi IDE1 o 2, purché l'hard disk sia attaccato a quello collegato. Importante sia collegato il floppy disk, altrimenti il diagnostico del computer ferma l'avvio. In (9) ci sono i due connettori per le porte USB 2.0, che sono date insieme alla scheda madre se essa le supporta (le ultime schede madri si). Una volta collegate, queste porte vanno invitate sul retro del case (come una scheda PCI). Nei due punti indicati con (10) ci sono i connettori per la ventola del dissipatore (CPU FAN) e per un'eventuale ventola di sistema (SYS FAN). Il dissipatore si monta sopra al processore, è costituito da due parti, una è il dissipatore vero e proprio, cioè un blocchetto di materiale conduttore (rame è il migliore, ma costano di più) che poggia sopra al processore, l'altra è la ventola, che si invita sopra a questo blocchetto, e serve per buttare fuori il calore della CPU. Infine in basso a destra ci sono i connettori indicati con PWR_LED: a questi si devono attaccare i connettori dei fili che partono dal pulsante di accensione presente sul case, che sono il reset, il power, il caricamento dell'hard disk e lo speaker interno del PC.

![]()

![]()

LE SCHEDE DI ESPANSIONE

Le schede che si possono inserire successivamente vengono chiamate schede di espansione; gli slot di espansione permettono di aggiungere schede extra: di solito ci sono almeno tre slot. Le schede adattatrici servono per il controllo delle unità disco o delle funzioni video (o anche per periferiche esterne come l'adattatore di I/O per la stampante) e vengono innestate negli slot di espansione, se non sono già inglobate nella scheda madre.IL MICROPROCESSORE

Il microprocessore è un chip in cui è realizzato l'elemento CPU del computer; contiene componenti elettronici capaci di eseguire operazioni aritmetiche. Ve ne sono di diversi tipi ("famiglie" di microprocessori) che presentano architetture differenti; per esempio i microprocessori INTEL 8080 (8088, 8086, 80286, 80386, 80486) utilizzati sui computer IBM, hanno un'architettura diversa dai microprocessori Motorola utilizzati sui computer Apple. Programmi scritti per funzionare con una famiglia di microprocessori non funzionano su microprocessori con architettura diversa; ma tra i microprocessori della stessa famiglia esiste una "compatibilità verso il basso"; questo significa che i programmi scritti per microprocessori di serie precedenti continuano a funzionare senza modifiche anche su computer con microprocessori più recenti. Oltre a Intel e Motorola altri importanti produttori di chip sono Cyrix e Amd. Attualmente i microprocessori più diffusi sono gli 80486, chiamati comunemente 486, (mentre i 286 e i 386 sono quasi scomparsi) e il nuovo Pentium, della Intel, installati sui computer IBM.Produzione robotizzata di microprocessori

Coprocessore matematico

Oltre al microprocessore principale può essere presente un coprocessore matematico che permette di migliorare le prestazioni dei programmi che richiedono molti calcoli, come per esempio i fogli elettronici o le applicazioni CAD. Il coprocessore è un tipo particolare di microprocessore, progettato per eseguire istruzioni matematiche in modo più efficiente; lavora in coppia con il microprocessore principale; quando quest'ultimo trova un'istruzione del set del coprocessore, gliela passa con i dati perchè la elabori. Può essere un chip separato da aggiungere in uno slot vuoto o può essere già incorporato nella CPU o nella scheda madre. I processori delle ultime generazione presentano un sensore termico al fine di mostrare al sistema operativo la temperatura di esercizio oltre che la possibilità di interrompere il funzionamento nel caso di sovrariscaldamento.Se il processore viene fatto operare ad una velocità più elevata di quella nominale, l'energia termica sviluppata dallo stesso aumenterà drasticamente con carichi elaborativi elevati (codifica filmati, impegnative elaborazione matematiche, rendering d'immagine, ecc.). Inoltre, non sempre il sensore di temperatura interno al processore riuscirà ad essere d'aiuto, in quanto potrebbe rilevare troppo tardi un repentino innalzamento della temperatura di core. Il core per l'appunto è la parte del processore che è racchiusa dall'involucro del processore stesso, mentre il sensore di temperatura si trova spesso all'esterno o ai bordi dell'involucro. Per ovviare a spiacevoli inconvenienti dovuti ad un surriscaldamento (overheat) della CPU (con conseguente blocco del sistema e possibili danni irreparabili all'hardware) è necessario, quindi, fare in modo che il core del processore, a sistema avviato ed a pieno regime di elaborazione, si trovi molto al di sotto della temperatura di funzionamento nominale dichiarata dal costruttore. Al fine di mantenere costante la temperatura del processore si utilizzano dei dissipatori, montati a stretto contatto con la superficie del processore. Nel caso di overclock della cpu, la temperatura nominale di esercizio ovviamente aumenta e con essa anche i rischi di bruciare sia il processore stesso, sia la scheda madre sottostante.

L'80486

Il 486 è un processore a 32 bit, con incorporato un coprocessore matematico per effettuare calcoli matematici a gran velocità; è diffuso in vari modelli. I 486 della serie SX hanno il coprocessore matematico disabilitato; costano quindi meno degli altri 486 ma hanno prestazioni inferiori, anche se comunque superiori rispetto a quelle dei 386. I 486 della serie DX sono più potenti e veloci. I 486 della serie DX2 si differenziano dai DX per un circuito che raddoppia la frequenza di clock all'interno del chip; il clock esterno (quello del bus) rimane però lo stesso ; quindi in un 486 DX a 50 MHz tutto ciò che è connesso alla CPU funziona a 50 MHz, mentre in un 486 DX2 25/50 Mhz i componenti esterni alla CPU funzionano a 25 MHz. La prima frequenza di clock di un computer IBM fu 4,77 MHz. Attualmente le frequenze più comuni sono 25 o 33, o il doppio (50 o 66 MHz). Il raddoppio del clock consente di accellerare di 2 volte la velocità ma il vantaggio non è notevole se il bus che si usa è lento. Le CPU 486 Intel ospitano 8 Kbyte di memoria cache al loro interno; per ottenere un'efficienza maggiore è possibile installare una cache esterna o di secondo livello. L'efficienza non è direttamente proporzionale alla quantità di cache installata; in altre parole, è opportuno ricordare che per migliorare le prestazioni bisogna aumentare considerevolmente la quantità di cache; i costi della memoria cache (che è una SRAM, cioè una RAM statica) sono piuttosto elevati. Una soluzione adeguata nella maggior parte dei casi è una cache di 128 Kbyte.I 586

Per far fronte all'uscita dei Pentium, Cyrix, AMD produce microprocessori 586 a 100 e 133 MHz compatibili con mother board 486. Le prestazioni si pongono fra quelle dei Pentium 60 e quelle dei 486 DX4 a 100 MHz ma la diffusione di questo tipo di processori resta piuttosto limitata, anche per la rapida affermazione sul mercato dei più veloci processori Intel.I Pentium

La continua evoluzione dei pacchetti software e delle applicazioni professionali, soprattutto quelle legate alle elaborazioni grafiche, ha spinto i produttori hardware a incrementare ulteriormente le prestazioni dei microprocessori Pentium, aumentando la velocità di clock e creando nuove tipologie. Nel volgere di pochi mesi si sono così succeduti microprocessori Intel Pentium da 90 MHz fino a 266 MHz, sempre con architettura a 64 bit e BUS PCI. Parallelamente si è sviluppata una nuova famiglia di processori Pentium, contraddistinta dalla sigla Pro. I Pentium Pro 166 e 200 MHz si presentano come piattaforma hardware ideale per i sistemi operativi a target professionale (quali Windows NT) e per applicazioni che richiedono una certa "robustezza", come nel caso dei sistemi server, grazie all'ottimizzazione per l'esecuzione di codice a 32 bit. Il loro alto costo iniziale, l'incompatibilità con le mother board Pentium e qualche difficoltà nella compatibilità con le vecchie applicazioni a 16 bit li hanno tuttavia resi poco appetibili al grande mercato. I Pentium Pro restano tuttavia un punto di riferimento, avendo una velocità di trasferimento dati alla cache fino a 5 volte superiore a quella dei Pentium normali. La caratteristica principale dell'architettura Pentium Pro è quella di consentire alla CPU di iniziare una operazione prima di aver concluso la precedente, avvalendosi di un algoritmo che prevede quali saranno le operazioni successive richieste alla CPU. A partire dal 1998 si sono diffusi i processori Pentium della seconda generazione, gli Intel Pentium II, con mother board specifica e velocità di clock fino a 450 MHz. In breve si sono resi disponibili anche i processori di pari prestazioni di AMD (K6-2) e Cyrix (686-2), di prezzo nettamente inferiori e compatibili con le schede madri Pentium I. A partire dal 1999 la Intel ha commercializzato i processori Pentium III, con velocità di clock superiore a 500 MHz.La tecnologia MMX

In qualche modo legata alla grande diffusione delle applicazioni multimediali è invece l'uscita di processori Pentium con applicazione della tecnologia MMX (Multi Media eXtension). I nuovi chip MMX hanno una cache interna raddoppiata (da 16 a 32 Kbyte), per migliorare gli scambi di informazioni fra RAM e CPU, e offrono un set di 57 nuove istruzioni dedicate alla gestione della grafica e dell'audio che rendono più veloci i cicli di calcolo della CPU su dati multimediali. Per godere di tutti i vantaggi offerti dalla tecnologia MMX e incrementare le prestazioni del proprio sistema fino al 60 % è necessario tuttavia adottare i nuovi applicativi che gestiscono il nuovo set di istruzioni. Sul terreno MMX si sono fronteggiati ad armi pari i grandi produttori: Intel, AMD e Cyrix. AMD esce con i microprocessori K6 e Cyrix con i cosiddetti 686. La velocità di clock giunge fino a 233 MHz, mentre le prestazioni si approssimano a quelle dei Pentium Pro. Nel 1997 la Intel lancia sul mercato i processori Pentium II con velocità di clock che sale fino a 400 MHz e mother board con slot one. L'indubbio vantaggio offerto dai K6 AMD sta nella compatibilità con lo zoccolino Socket 7, quello su cui vengono montati i processori Pentium, compatibilità che consente di realizzare cospicui risparmi sui costi. Nel 1999 vengono commercializzati i Processori Pentium III, con velocità di clock fino a 600 MHz e mother board con slot one o con socket specifico. Con prestazioni simili è stato lanciato alcuni mesi dopo il K7 di AMD.I Pentium II e Pro

È un microprocessore x86 prodotto da Intel. Fu lanciato il 7 maggio 1997. Era basato sull'architettura "P6" sviluppata per il Pentium Pro, inizialmente destinato a sostituire il primo Pentium ma poi relegato al mercato di fascia alta. Rispetto al Pro, il Pentium II offre migliori prestazioni nel codice a 16 bit e supporta le istruzioni MMX introdotte con le tarde versioni del primo Pentium. La prima versione del Pentium II, chiamata Klamath, era cloccata a 233 e 266 Mhz, ed era prodotta con un processo a 0.35 µm. Per quei tempi, produceva un'enorme quantità di calore. Era inoltre dotata di un FSB a 66 Mhz, una velocità inadeguata che non permetteva al processore di mostrare il suo vero potenziale. Una versione a 300 Mhz fu rilasciata più avanti nel 1997. I Pentium II con architettura Deschutes debuttarono nel gennaio del 1998 ad una velocità di 333 MHz. Questi erano prodotti con un più appropriato processo a 0.25 µm, e scaldavano in modo significativamente minore; erano inoltre dotati di un FSB a 100 Mhz, che permise notevoli miglioramenti nelle prestazioni. Nel 1998 furono rilasciate versioni a 266, 300, 350, 400, e 450 Mhz. Nei sistemi basati sul Pentium II fu introdotto un nuovo tipo di RAM, chiamato SDRAM (che rimpiazzava la EDO RAM), e il bus grafico AGP. A differenza dei suoi predecessori, il Pentium II non era fornito di un attacco socket ma era incluso in un involucro che si inseriva in uno slot. Questo era un compromesso che permetteva a Intel di separare la cache L2 dal processore, ed evitare i problemi di produzione avuti col Pentium Pro, mantenendola tuttavia collegata strettamente al processore con un bus molto veloce. Questa cache però, a differenza di quella dei precedenti Pentium, funzionava ad una velocità di clock pari alla metà di quella del processore. Una versione economica del Pentium II (sostanzialmente un Pentium II con poca o nessuna cache L2) fu chiamata Celeron. La versione per i server fu chiamata Pentium II Xeon. Il Pentium II fu sostituito dal Pentium III all'inizio del 1999.I Pentium III

Il processore Intel Pentium III è stato progettato con particolare attenzione a Internet. Una delle nuove caratteristiche ideate per ottimizzare l'esperienza di navigazione su Internet è il numero di serie del processore, un numero elettronico di cui ogni processore di terza generazione è dotato. In questo modo, gli utenti possono trarre vantaggio dalla maggiore sicurezza sul Web (a proposito di sicurezza in rete cfr. Capitolo su Internet). Infatti, se utilizzato unitamente a user name e password, il numero di serie del processore può essere impiegato dai siti Web per aumentare il livello di sicurezza ad esempio durante una transazione di e-commerce, oppure per creare Chat Room con accesso riservato. Ogni utente di un processore Intel Pentium III è in grado di compiere la propria scelta in merito all'utilizzo del numero di serie del processore. Ad esempio tale numero di serie fortunatamente non può trasmettere o diffondere informazioni su Internet. In generale, l'utente dovrà autorizzare espressamente la lettura del numero di serie del processore da parte di un sito Web. Infatti per poter leggere il numero di serie del processore, i siti Web dovranno eseguire un programma sul sistema dell'utente collegato, e le impostazioni di sicurezza di default dei browser Web più diffusi prevedono che l'utente venga avvisato prima di dare avvio all'esecuzione di un programma. Perciò sarebbe conveniente fare sempre la massima attenzione prima di autorizzare l'esecuzione di qualunque programma da un sito Web non conosciuto. Per gli utenti che intendono avere la possibilità di disabilitare il numero di serie del processore, Intel ha messo a disposizione un software che disabilita automaticamente questa funzione, e permette agli utenti di abilitarla soltanto se decideranno di farlo. Questo software è distribuito in modo gratuito tramite il sito Web di Intel ed altri canali. Ecco una breve storia del processore con alcune sue caratteristiche tecniche: Il Pentium III fu introdotto il 26 Febbraio 1999. I primi PIII erano dei PII a cui sono state aggiunte 70 nuove istruzioni multimediali (SSE - Streaming SIMD Extensions). In pratica l'unico vantaggio rispetto al PII era che lavora a frequenze più elevate poiché non esistevano ancora software ottimizzati per le SSE. Caratteristiche tecniche: - 9,5 milioni di Transistor con una lunghezza di canale di 0,25 micron - Frequenza di bus 100 MHz - Cache L1 32KByte (full speed) - Cache L2 512 KByte (half speed) - Memoria indirizzabile 64 GByte. Il 27 Settembre Intel sforna i PIII 600B e 533B con frequenza di bus a 133 MHz. I cambiamenti più sostanziosi arrivano però nell'ottobre del 1999 quando vengono presentati i nuovi PIII con 256 KB di cache L2 funzionante a piena velocità ed integrati nel core del processore, scompare ,quindi, la cache esterna da 512 KB. Il nuovo processore, comunemente noto come Coppermine, è realizzato in tecnologia 0,18 µm. La cache L2 ha subito anche altri miglioramenti che l'hanno resa più veloce ed efficiente. Il core vero e proprio del processore (Fpu, pipelines...) non è stato cambiato. L'eliminazione della cache esterna da 512 KB fa venir meno la necessità dello slot 1. Infatti Intel produce anche PIII su socket (FC-PGA). Per riassumere il tutto ecco una tabella:| Modello | FSB | Cache L2 [KB] | Frequenza della Cache L2 [MHz] | Data di Rilascio | Supporto |

| 1000 | 133 | 256 | 1000 | 8 Marzo 2000 | Slot 1 |

| 866 EB | 133 | 256 | 866 | 20 Marzo 2000 | Slot 1 |

| 850 E | 100 | 256 | 850 | 20 Marzo 2000 | Slot 1 |

| 800 E | 100 | 256 | 800 | 20 Marzo 2000 | Slot 1 |

| 750 E | 100 | 256 | 750 | 20 Marzo 2000 | Slot 1 |

| 733 EB | 133 | 256 | 733 | 20 Dicembre 1999 | Slot 1 |

| 700 E | 100 | 256 | 700 | 25 Ottobre 1999 | Slot 1 |

| 667 EB | 133 | 256 | 667 | 25 Ottobre 1999 | Slot 1 |

| 650 E | 100 | 256 | 650 | 25 Ottobre 1999 | Slot 1 |

| 600 E | 133 | 256 | 600 | 25 Ottobre 1999 | Slot 1 |

| 600 B | 133 | 512 | 300 | 25 Ottobre 1999 | Slot 1 |

| 600 | 100 | 512 | 300 | 27 Settembre 1999 | Slot 1 |

| 550 E | 100 | 256 | 550 | 2 Agosto 1999 | FC-PGA |

| 550 | 100 | 512 | 275 | 25 Ottobre 1999 | Slot 1 |

| 533 EB | 133 | 256 | 533 | 17 Maggio 1999 | Slot 1 |

| 533 B | 133 | 512 | 267 | 25 Ottobre 1999 | Slot 1 |

| 500 E | 100 | 256 | 500 | 27 Settembre 1999 | FC-PGA |

| 500 | 100 | 512 | 250 | 26 Febbraio 1999 | Slot 1 |

| 450 | 100 | 512 | 225 | 26 Febbraio 1999 | Slot 1 |

I Pentium IV

Intel ha utilizzato come architettura interna del suo processore di ultima generazione il NetBurst(TM), grazie al quale è possibile gestire più agevolmente il multitasking (decodifica dati, compressione video, peer-to-peer networking... Inoltre proprio grazie alla tecnologia NetBurst i processori Pentium IV hanno un bus a 400 Mhz), soluzione che, grazie alla Rapid Execution Engine (REE = un micro-engine che funziona con un particolare sistema di calcoli in addizione e sottrazione), renderà una velocità di processo dei dati pari al doppio del "vecchio" processore di terza generazione consentendo un miglioramento delle prestazioni per quanto riguarda la grafica 3D e le moderne tecnologie Internet. Secondo Paul Otellini, Executive Vice President e General Manager dell'Intel Architecture Group "questo processore è stato progettato per soddisfare i requisiti informatici più elevati, ad esempio per i contenuti streaming, i videogame interattivi, la codifica di video e di file MP3 o la creazione di contenuti per Internet". Il Pentium IV ha una velocità da 1,4 Ghz in su ed è costituito da 42 milioni di transistor contro i 28 milioni del Pentium III. Un'ulteriore innovazione è costituita dalla funzione Advanced Dynamic Execution che incrementa la velocità del processore in quanto vengono priorizzate alcune delle funzioni più importanti. Il chip sarà in grado di lavorare gestendo contemporaneamente 6 istruzioni per ogni singolo ciclo di clock. Il nuovo processore inoltre contiene 144 istruzioni multimediali in più rispetto al Pentium III per migliorare grafica e sonoro. Diversamente da come avviene con i Pentium della precedente generazione, il nuovo FSB permette di ottenere una velocità molto più elevata grazie ad una nuova tecnologia in grado di dividere ogni ciclo di clock. La versione a 1.5 Ghz del nuovo Pentium consente di ottenere performance del 50% superiori rispetto a quelle offerte da un Pentium III a 1 Ghz. La Intel ha presentato in seguito il processore Pentium IV a 2 Ghz, dotato di un particolare sistema di raffreddamento.I Pentium M e Centrino

Introdotto il 12 marzo 2003, il Pentium M è un microprocessore con architettura x86 progettato e costruito da Intel destinato all'utilizzo in computer portatili. Il suo nome in codice prima della commercializzazione era Banias (questo è il nome in codice della prima generazione, poi è arrivato Dothan e altre seguiranno a breve). I nomi in codice dei Pentium M traggono tutti ispirazione da altrettante località israeliane, dove risiede il gruppo di sviluppatori del Pentium M. Non si tratta di una versione a basso consumo del Pentium IV, orientato al mercato desktop, ma è piuttosto una versione profondamente modificata del Pentium III (a sua volta una versione modificata del Pentium II che era un'evoluzione del vecchio Pentium Pro con l'aggiunta delle istruzioni MMX). È ottimizzato per un basso consumo, una caratteristica fondamentale per estendere la durata della batteria dei computer portatili. Per consumare, e riscaldare, molto meno di un processore per computer desktop, il Pentium M utilizza un clock molto inferiore rispetto al contemporaneo Pentium IV, ma con prestazioni molto simili (un Pentium M a 1,4 Ghz tipicamente ha prestazioni confrontabili o superiori a quelle di un Pentium IV Northwood a 2,4 Ghz (con bus a 400 Mhz, senza la tecnologia Hyper-Threading). La cache secondaria, che in genere consuma molta potenza, utilizza un metodo innovativo di accesso per evitare attivazioni di sue parti a cui non si farà accesso. Altri metodi per limitare i consumi sono la frequenza di funzionamento variabile e un voltaggio ridotto, che permettono al Pentium M di "rallentare" (riducendo il clock tipicamente a 600 Mhz) quando il sistema è inattivo o in modalità di risparmio energetico. Intel ha scelto tale tecnologia per offrire sui sistemi mobile, oggi disponibili, un nuovo cuore, la piattaforma denominata Centrino.I PROCESSORI AMD

Da decenni, in concorrenza con Intel la società AMD ha prodotto analoghe versioni di processori altrettanto potenti ai Pentium: i nomi sono altrettanto fantasiosi, spesso legati a pure sigle mnemoniche ma che per i più tecnici rappresentano punti di svolta tra tecnologie differenti e sempre più ottimizzate. La gamma K5 fu prodotta negli anni 1995, la K6 ha seguito in parallelo i Pentium I-III negli anni 1996-2001, il K7, Athlon, Duron e Sempron rappresentano la scalata, a colpi di frequenze, con il Pentium IV. Spesso tecnologie di produzione apparentemente simili hanno dato volta ad ambiguità, ma AMD è riuscita sempre a mantenere un suo brand, una sua posizione nel mercato, sia grazie alla sua politica commerciale, sia per le prestazioni che in alcuni processori hanno superato il concorrente Intel. Per esempio le CPU Sempron sono l'offerta per i desktop della AMD. Rimpiazzando i processori Duron, sono in competizione con i Celeron D della Intel con frequenze differenziate tra processore e memorie cache a due livelli (frequenza di clock: 1600 - 2000 Mhz, 128 K L2-Cache: 2800+, 3200+, 3500+ e 256 K L2-Cache: 3000+, 3400+, 3600+Con la gamma K8 ed Opteron, dal 2003 si è passati allo sviluppo di processori a 64 bit, ideali per piattaforme mono e pluri processore, ottimizzati per sistemi operativi Unix e Linux.

Infine nel settore dei portatili le versioni Turion 64 e X2 si sono diffusi per qualità e ridotto consumo elettrico, in competizione con il Pentium M di Intel, bassa dissipazione termica e processo costruttivo a 90 nanometri (Core Lancaster).

ALTRI PROCESSORI

Su un personal computer la CPU non è l'unico processore presente; in genere ve ne sono altri dedicati a funzioni particolari, quali la gestione del video, dei driver o della stampante. Alcune operazioni possono così essere fatte in contemporanea; si può eseguire il rinfresco del video o la stampa batch mentre si effettua un'elaborazione oppure si può immettere un comando mentre terminano le operazioni sul drive.I SOCKET

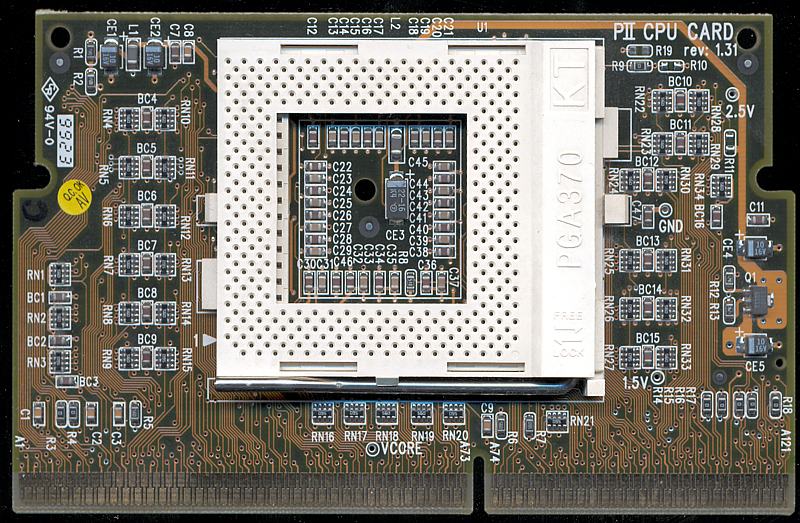

Il Socket è l'alloggiamento del processore sulla motherboard. È formato da un determinato numero di "piedini" che varia da tipo di Socket a tipo di Socket, che sono presenti in corrispondenza dei pin di collegamento del processore. Generalmente esso è quadrato, ma ci sono state nel tempo delle serie rettangolari e persino verticali (vedi caso Pentium II). L'uso del Socket è nato dopo che apparvero i primi computer negli anni '80: trodotto significa zoccolo. Lo scopo è quello di poter montare e smontare a piacimento un porcessore al fine di sostituirlo con un altro di fascia più alta, senza dover sostituire l'intera motherboard. Questa idea iniziale si è negli anni modificata, più nella visione di poter agevolmente produrre motherboard che soddisfino standard diversi senza dover necessariamente riprogettare tutto. Ecco perché in ordine cronologico sono comparsi diversi tipi di Socket sul mercato che hanno anche convissuto in tempi simili in quanto diversi processori (di produttori come Intel, AMD, IBM, Cyrix) utilizzavano Socket differenti. Per esempio per Intel si parte dalla serie Socket 1-3 per i x486, poi i Socket 4 per i primi Pentium I, poi i Socket 8 per i Pentium Pro, poi la serie Socket 370 per i Pentium Celeron e quelli a Slot 1 e 2 per i Pentium II/III, poi la i Socket 423, 478, 479 per i Pentium IV da 1.3 a 2,8 Ghz e Pentium M, poi al Socket 603,604,PAC418 e PAC611 per i Pentium Xeon da 2.8 a 3,6 Ghz e Itanium, infine il Socket 775 e LGA775 per i Pentium più veloci. Proprio per quest'ultimo tipo di Socket, l'abbreviazione LGA sta per Land Grid Array e la differenza principale riguarda i pin, non più presenti sulla CPU ma spostati sul Socket della motherboard.Evoluzione della scheda madre Socket 370

IL DISSIPATORE

Il dissipatore è generalmente una parte metallica di varia forma a diretto contatto con la superficie del processore o della periferica. Per migliorare il coefficiente di dissipazione termica della CPU vanno adottati o consolidati due aspetti specifici:- utilizzo della pasta termoconduttiva (o gel termico) al posto del più scadente PAD termico;

- miglioramento della superficie dissipante (questa procedura è detta lapping, o lappatura).

La pasta termica è un composto non conduttivo a base minerale della consistenza di un gel in grado di aumentare la coesione termica tra due superfici secondo quanto enunciato nel Primo principio della Termodinamica. La pasta (o gel) viene posizionata tra il processore interessato ed il dissipatore che vi è sovrapposto. Per migliorare l'efficienza della superficie dissipante, caratteristica essenziale di ogni dissipatore, indicata in centimetri quadri totali e caratterizzata dal coefficiente di conduttività termica del materiale utilizzato, si può operare pulendo il vecchio dissipatore. Rimuovendo la polvere ed il grasso presenti tra le lamelle del dissipatore è possibile riportare lo stesso alla sua funzionalità caratteristica nominale ed ottimizzarne il funzionamento.

Esistono in commercio, inoltre, dissipatori con coefficiente di dissipazione molto elevato, adatti agli scopi in oggetto: l'acquisto di un dissipatore maggiorato è fortemente consigliato per garantire la buona riuscita e la stabilità a lungo termine di un overclock per esempio. Se non si volesse utilizzare un dissipatore con coefficiente di dissipazione nominale molto elevato, è possibile procedere al lapping, che consiste nel rendere più piana e liscia la superficie del dissipatore per aumentarne il coefficiente di dissipazione. Questo si ottiene artigianalmente tramite carta vetrata molto sottile o con paste abrasive varie. I più esperti riescono a guadagnare alcuni gradi grazie al lapping. Ci sono però casi (come nella macchine workstation o superiori) che il raffreddamento mediante i dissipatori metallici non sia sufficiente. Essendo l'energia termica da dissipare troppo elevata, si utilizzano metodi alternativi di raffreddamento:

- a liquido

- a celle di Peltier e liquido

- ad immersione

Per raffreddare una CPU a liquido viene disposto sulla CPU un supporto all'interno del quale passa dell'acqua. L'acqua viene quindi spostata con una pompa attraverso un circuito idrico fino all'esterno del case dove viene poi raffreddata tipicamente in modo attivo mediante l'uso di un radiatore ed una ventola; in alcuni casi l'acqua viene fatta transitare attraverso grandi dissipatori in alluminio alti alcune decine di centimetri che, data la loro grande superficie dissipante e le ottime caratteristiche termiche nell'alluminio, non necessitano di alcuna ventola e rimangono quindi totalmente silenziosi.

La soluzione a celle di Peltier consiste nell'accostare alla CPU, mediante pasta termica, una cella e quindi disporre il supporto di raffreddamento descritto nell'esempio precedente sopra la cella stessa. In questo modo si forza elettricamente lo spostamento dell'energia termica e si utilizza il circuito di raffreddamento per spostare all'esterno l'energia così raccolta. Il problema di questa soluzione è che può accadere che la parte esterna del processore si trovi a temperature molto basse, nonostante l'overclock, tanto da causare la formazione di condensa in quantità tali da causare il blocco/danneggiamento funzionale dell'intero sistema.

Il metodo ad immersione richiede di immergere il processore con tutta la motherboard in una sostanza liquida, non conduttiva, a base minerale e tipicamente trasparente. In questo modo oltre a sfruttare la superficie di contatto del processore predisposta dal costruttore, si riesce ad indirizzare lo scambio termico anche sulla motherboard, il retro del processore, il chipset e le memorie. La soluzione comporta però alcuni inconvenienti: il tutto risulta ingestibile nel caso la configurazione dell'hardware vada spesso modificata, inoltre tutto ciò che di mobile si trovava nel case (interruttori, connettori, cd-rom, hard disk, ecc.) va spostato al di fuori del recipiente che conterrà solamente il liquido refrigerante e la motherboard. Infine le ventole non sono concepite per spostare un liquido ma l'aria: risulta difficile, quindi, escogitare un sistema per far muovere il liquido nel recipiente e rendere così omogenea la temperatura in ogni parte del sistema.

A volte le potenze in gioco rendono comunque necessario raffreddare il fluido esternamente mediante un radiatore ed una ventola. Insomma, una soluzione di difficile approccio, ma che attualmente garantisce i risultati migliori.

![]()

![]()

IL BUS

Il bus permette la comunicazione dei dati dal processore a tutti gli altri dispositivi e viceversa, e può influire notevolmente sulle prestazioni del personal computer. Sul bus vengono inserite, negli appositi slot, le schede di memoria e le schede per la gestione dei diversi dispositivi. Quando si acquista un personal, alcuni slot possono essere già occupati, mentre alcuni slot rimangono liberi per poter inserire nuove schede e ampliare le prestazioni del PC. Le schede da inserire negli slot devono essere compatibili rispetto al bus in uso. Ci sono bus a 8, 16, 32 e 64 bit; maggiore è il numero di bit, maggiore è il numero di dati che possono essere trasmessi e quindi maggiore è la velocità ottenibile. Il bus funziona con una propria velocità di clock, che di solito è un sottomultiplo di quella del microprocessore.TIPI DI BUS

Il bus ISA (Industry Standard Architecture) funziona con un clock di 8.3 MHz indipendentemente dal clock della CPU e ha una velocità di trasferimento dati pari a 5Mb/sec. L'ampiezza era di 8 bit nelle prime versioni, attualmente è di 16 bit. Il bus EISA (Enhanced Industry Standard Architecture) ha la stessa velocità di clock, ma trasferisce i dati a 32 bit, con una velocità di trasferimento di 33Mb/sec. Il bus VESA (Very Enhanced Standard Architecture) è un bus ISA con tre slot aggiuntivi che consentono di migliorare le prestazioni destinati alla scheda video, al controller dell'hard disk e alla scheda per il collegamento in rete del personal. Non è molto più costoso dell'ISA ed è molto veloce: può trasferire fino a 120 Mb al secondo. Il bus PCI (Peripheral Component Interconnect), adottato sui computer con processore Pentium ha caratteristiche molto diverse, con una velocità di trasferimento di 250 Mb al secondo. Il prezzo è piuttosto elevato e, trattandosi di uno standard recente, la disponibilità di schede dello stesso tipo è limitata. I bus EISA, VESA e PCI sono compatibili ISA; questo significa che le schede ISA possono essere inserite anche negli slot di questi bus e funzionano ugualmente, pur non sfruttando completamente tutte le loro caratteristiche, come avverrbe invece con le schede adeguate. Un altro tipo di bus, utilizzato dalla IBM sui personal PS/2 è il bus MCA (Micro Channel Architecture), realizzato in diverse versioni, a 16 o 32 bit; questo bus, però, non è compatibile ISA.Evoluzioni ulteriori sono il bus AGP e quello PCI-Express, al fine di ottimizzare le funzionalità offerte dalle più moderne schede video.

IL BUS PCI

Per superare il problema della lentezza delle comunicazioni con i dispositivi collegati al bus ISA, i progettisti avevano pensato inizialmente di interfacciare direttamente le periferiche veloci con il local bus del processore, cioè con il bus che esce dal microprocessore, invece che con il bus di espansione (quello che permette di collegare altri componenti come drive e stampanti); ma, ogni volta che diventava disponibile un processore più veloce, bisognava riprogettare l'intero sistema di I/O del PC. Inoltre il collegamento non era standard: ogni produttore di motherboard creava una modalità proprietaria di collegamento; bisognava quindi acquistare nuove periferiche solo dal fornitore originale della motherboard. Il bus PCI è collegato al local bus del processore con un chip bridge, che fa da ponte; le periferiche PCI sono connesse al bus PCI. In questo modo il bus PCI è indipendente dal processore; se quest'ultimo cambia, basta sostituire solo il chip bridge. Il bus PCI è caratterizzato da un'elevata capacità di trattamento dati ed è predisposto per future evoluzioni; si propone come un nuovo standard, anche se richiede molteplici componenti, con una conseguente diminuzione dello spazio sulla motherboard e un aumento dei costi.BUS AGP

L'Accelerated Graphics Port (AGP) è stata sviluppata da Intel nel 1996 come modo per aumentare le prestazioni e velocità delle schede grafiche connesse ai PC. Si basa sullo standard PCI 2.1, e per questo la frequenza base a cui opera è di 66 Mhz. Il trasferimento dei dati avviene in modalità parallela, per cui non è possibile una comunicazione bidirezionale contemporanea.L'idea con cui venne creata è quella di permettere un accesso diretto alla memoria fisica del computer da parte della scheda grafica, in modo da poter gestire texture e oggetti 3D molto voluminosi. Lo slot AGP compare per la prima volta su una scheda madre con il chipset Intel 440LX, prodotto all'inizio del 1997. In breve tempo la Nvidia sviluppa le prime schede grafiche basate su GPU TnT, e il chipset rivela i suoi problemi nel fornire una corretta alimentazione alla scheda grafica. Le soluzioni ricercate sono di due tipi diversi: alcuni produttori si affidano alla successiva versione del chipset Intel, il modello 440BX, che supporta l'alimentazione a 3,3V. Altri riducono la dimensione delle GPU passando da 0.25 nanometri a 0.18 nanometri. Questo permette di ridurre il consumo elettrico, il calore generato e inoltre permette significativi aumenti della frequenza. Nell'aprile del 1999 viene rilasciata la specifica dell'AGP Pro, ritenuta la soluzione a tutti i problemi di alimentazione. AGP Pro è retro-compatibile, e viene prodotto in tre versioni diverse: la 1,5V, la 3,3V e la versione Universal, compatibile con entrambi i voltaggi. Lo slot AGP assume così dimensioni e configurazioni diverse a seconda dei voltaggi, in modo da non poter inserire una scheda nello slot di tipo errato. Gli slot AGP Pro vengono ulteriormente perfezionati, in modo da poter fornire prima fino a 25W, e successivamente 50 e addirittura 110W di potenza. Inoltre, viene incrementata la frequenza di trasmissione dati per ottenere un flusso sempre maggiore tra la scheda video e la memoria fisica.

La prima versione dello slot AGP raddoppiava la frequenza di un normale slot PCI, raggiungendo quindi i 133 Mhz. Successivamente le versioni 2.0 e 3.0 hanno raddoppiato ogni volta la frequenza, fino a raggiungere i 533 Mhz odierni. Per prevenire problemi di compatibilità tra le differenti versioni, è previsto il funzionamento in modalità 1x, quindi a 66 Mhz. Questa modalità viene attivata automaticamente dal BIOS in caso di problemi.

La molteplicità delle possibili velocità di trasmissione dei dati e dei voltaggi ha portato a problemi di compatibilità, specialmente per quanto riguarda le vecchie schede madri. A partire da quei modelli che supportano l'AGP 3.0, i produttori si sono sforzati per supportare tutte le possibili configurazioni. Gli ultimi modelli di schede grafiche, come ad esempio la serie 6800 ultra della Nvidia, richiedono troppa potenza perché lo slot AGP possa sopperire a questa richiesta. Così, sono in commercio alcune schede grafiche con connettori MOLEX. Questo verrà abbandanato grazie alle specifiche di alimentazione del PCI Express, molto maggiori rispetto a quelli dell'AGP.

PCI EXPRESS

Questo bus è l'evoluzione del bus di espansione PCI, introdotto con i primi Pentium che sta anche prendendo il posto della vecchia interfaccia per schede grafiche, l'AGP.È basato su un trasferimento dei dati seriale, a differenza di quello parallelo del PCI, che semplifica il layout del PCB delle schede madri ed è costituito da una serie di canali. Ciò consente una notevole modularità, in quanto possono essere aggregati più canali per aumentare la banda passante disponibile o per supportare particolari configurazioni come l'utilizzo di due o più schede video. Inoltre la bandwidth di ciascun canale è indipendente da quella degli altri.

Anche se il nome è lo stesso, il PCI Express si divide in due tipi:

- PCIx1, costituito da un singolo canale, che offre una bandwidth full duplex di 266 MBytes/sec. e che diventerà il sostituto "ufficiale" del vecchio standard PCI. Una caratteristica "curiosa" sono le dimensioni, nettamente inferiori di quelle dello standard PCI e la "promessa" di praticare l'hot swap, ovvero di poter sostuire una scheda a PC acceso (ora impossibile per lo standard PCI ma già disponibile con SATA e USB).

- PCIx16, costituito da 16 canali, potendo offrire così il doppio della velocità rispetto allo standard AGP 8x, teoricamente in grado di trasferire 2,5 Gb/s sia in entrata che in uscita ma che si riducono a 250 Mb/s per l'encoding utilizzato.

Nei primi chipset in commercio offrivano un massimo di 20 canali, pertanto nel caso di un utilizzo simultaneo di due schede grafiche (nel caso della tecnologia sviluppata da Nvidia chiamato con l'acronimo SLI, Scalable Link Interface o nel caso di quella ATI chiamata Crossfire) i canali si riducono a 8x per ciascuna scheda, senza tuttavia evidenziare decadimenti prestazionali.

Nelle ultime incarnazioni del chipset Nvidia SLI-16X i canali sono stati praticamente raddoppiati, in attesa che i futuri applicativi CAD o ludici possano trarne giovamento.

PCI Express è infine progettato per sostenere il sempre maggior fabbisogno energetico delle schede video di ultima generazione. Infatti, a differenza dello slot AGP, in grado di erogare un massimo di 50W, l'attuale revisione di PCI-ex supporta carichi fino a 75W, permettendo così di eliminare il connettore MOLEX dalle schede di fascia media e medio-bassa anche se è rimasto per tutte le altre.

I BUS DI MEMORIA

Il bus di espansione funziona a una velocità inferiore a quella del microprocessore; le prestazioni della RAM sono ridotte se il bus è lento. La COMPAQ è il primo costruttore che ha separato il bus di espansione dal bus di memoria; il bus di memoria lavora alla stessa velocità di quello del microprocessore, così la memoria innestata su uno zoccolino del bus dedicato funziona più velocemente di quella installata sul bus di espansione.RAMBUS

Questo modulo lavora con recenti chipset tra cui i nuovissimi della Intel usati con tecnologia Pentium IV. Viaggiano a frequenze di clock comprese tra i 300 ed i 400 Mhz e sono in assoluto le più veloci. Sono infatti utilizzate soprattutto per coloro i quali hanno a che fare professionalmente con applicazioni grafiche in cui sono richieste ampie bande di memoria. Grazie alla tecnologia RSL esse riescono a raggiungere frequenze di transfer rate di 600-800 Mhz; con il termine transfer rate viene indicata la velocità del trasferimento delle parole in memoria. Inoltre, i bus di controllo di questa RAM sono suddivisi in righe e colonne, di modo da avere un controllo migliore e sempre più efficiente della stessa, ed inoltre garantire maggiori performance.GLI HARD DISK

Di solito gli hard disk vengono scelti in base alla loro capacità di immagazzinamento. Altri fattori che influiscono sulle prestazioni del disco sono: - il ritmo di trasferimento dei dati; - il tempo di accesso; Anche gli hard disk hanno subito una rapida evoluzione, determinata dal continuo sviluppo e appesantimento dei sistemi operativi e dei più diffusi applicativi di office automation, soprattutto nella capacità e nella velocità. Pressoché scomparse le vecchie unità da 5,25", troppo ingombranti per le più recenti filosofie ergonomiche applicate ai personal computer, i dischi rigidi da 3,5" seguono ancora due distinti standard: i più diffusi (in ambiente PC) sono gli EIDE (Enhanced Integrated Drive Electronic), giunti a una capacità di oltre 10 Gb; meno diffusi in ambiente PC ma con migliori performance generali, sono gli SCSI (Small Computer System Interface), da sempre con un migliore transfer rate. Gli hard disk SCSI hanno lo svantaggio del costo, oltre al fatto di necessitare di un controller (anch'esso SCSI) che per gli EIDE è spesso integrato alla mother board. I dischi SCSI restano comunque i più richiesti dall'utenza professionale, anche per la possibilità offerta dal controller di gestire supporti removibili, sistemi di backup ad altissima capacità, scanner. Ogni scheda SCSI può gestire fino a 7 e più periferiche SCSI diverse collegate in cascata. Inizialmente l'interfaccia funzionava soltanto con i dischi fissi. Solo in un secondo momento, un'estensione allo standard è stata realizzata per permettere il funzionamento con una varietà di dispositivi (quelli che in genere utilizzano dei media rimovibili). In linea di massima, tali dispositivi comprendono i lettori CD-ROM, le unità a nastro magnetico, floppy ad alta capacità quali lo Zip drive e il SuperDisk drive. Le estensioni prendono il nome Advanced Technology Attachment Packet Interface (ATAPI), con l'insieme noto come ATA/ATAPI. Il cambiamento da programmed input/output (PIO) a direct memory access (DMA) ha rappresentato un'ulteriore importante transizione nella storia dell'ATA. Di questi due metodi di accesso e trasferimento dei dati all'interno dei personal computer, il PIO si è dimostrato inefficiente, dal momento che esso richiede tempi di processo significativi da parte della CPU. Ciò significava che i sistemi basati su dispositivi ATA erano generalmente più lenti nell'effettuare operazioni di input/output rispetto a quei computer che utilizzavano sottosistemi SCSI o altre interfacce. Tuttavia il DMA (e in seguito l'Ultra DMA o UDMA) hanno ridotto enormemente il tempo di elaborazione necessario da parte della CPU a parità di dati letti o scritti sui dischi.I dispositivi ATA hanno sofferto di un certo numero di limitazioni e vere e proprie "barriere" in termini di capacità e di quantità di dati gestibili. Ogni volta nuovi sistemi di indirizzamento, uniti a tecniche di programmazione più sofisticate, hanno permesso di superare la maggior parte dei limiti, accompagnando di fatto la crescita dei dispositivi di memoria di massa alla quale abbiamo potuto assistere negli ultimi anni. Alcune delle limitazioni e barriere relative alle dimensioni massime dei dischi gestibili dall'interfaccia ATA includono: 504 Mb, 32 Gb e 137 Gb. Ci sono state altre limitazioni, spesso dovute a driver mal scritti o alle routine di supporto del sistema operativo. In molti casi, le limitazioni elencate derivavano da implementazioni non perfette del BIOS o ad aggiornamenti tardivi dello stesso da parte dei produttori di schede madri.

L'evoluzione tecnologica in questo ultimo decennio nella produzione degli hard disk ha permesso di raggiungere capacità incredibili a pari dimensioni: 100 Gb ormai sono una grandezza consueta ed a prezzi molto contenuti. Lo standard ATA (rinominato P-ATA ossia Parallel Advanced Technology Attachment) ha dal 2003 una nuova solzione, denominata S-ATA (Serial ATA).

L'interfaccia P-ATA è generalmente composta da connettori a 40 pin impiegati sia sulle unità sia sui controller, con collegamenti per mezzo di cavo a piattina. Ciascun cavo è dotato di due o tre connettori. I cavi P-ATA permettono il trasferimento di dati con 16 o 32 bit per volta. Per la maggior parte della storia dell'ATA, i cavi a piattina hanno avuto 40 fili conduttori. Una versione da 80 conduttori è comparsa con l'introduzione dello standard Ultra DMA/66. Il cavo con 80 conduttori prevede un filo di messa a terra per ciascun conduttore che porta il segnale. Ciò riduce gli effetti dell'induzione elettromagnetica tra i conduttori adiacenti e permette il transfer rate (velocità di trasferimento) di 66 megabyte al secondo (MB/s), proprio del UDMA4. Le modalità ancor più veloci, UDMA5 e UDMA6 richiedono anch'esse cavi con 80 conduttori. Sebbene il numero di conduttori sia raddoppiato, il numero di pin dei connettori è rimasto lo stesso, dal momento che i connettori sono fisicamente identici. Se due unità vengono collegate ad un solo cavo, è generalmente necessario configurare una delle due unità come master e l'altra come slave. L'unità master generalmente viene elencata prima di quella slave da parte del sistema operativo. L'unità master gestisce l'accesso ai dispositivi su quel canale. Per questa ragione, dispositivi come le prime versioni dei masterizzatori, che possono risentire nel funzionamento a causa dei tempi di latenza aggiuntivi necessari per l'arbitraggio da parte dell'unità master, dovrebbero essere configurati come master, inoltre ogni canale dovrebbe avere un master per funzionare correttamente.

Una configurazione possibile per alcune unità a disco è quella denominata cable select, realizzata solo in tempi recenti. In questa modalità, l'unità si configura automaticamente come master o slave. Questa funzione viene ottenuta tagliando il conduttore 28 sul cavo con 40 conduttori, o i conduttori 56 e 57 sul cavo con 80 conduttori) tra i due connettori riservati alle periferiche (HDD e CDROM). I cavi più recenti non recano alcun taglio nella piattina, dal momento che la disconnessione viene effettuata internamente sui connettori, che, in questo caso, sono sempre di colore diverso: nero il connettore per la periferica master, grigio il connettore per la periferica slave. Il connettore destinato all'inserimento sul controller (normalmente integrato nella scheda madre) è di colore blu.

Il Serial ATA (SATA) è una interfaccia per computer generalmente utilizzata per connettere un hard disk nell'ambito di un computer (recentemente sono state immesse sul mercato anche unità ottiche S-ATA). È l'evoluzione dell'P-ATA. I vantaggi principali sono tre: la velocità, la gestione dei cavi e la funzione di hot swap.

La prima versione del S-ATA (S-ATA 1.0) supporta una velocità di trasmissione dei dati pari a 150 Mb al secondo, la seconda 300 (S-ATA 2.0), ma è prevista una versione da 600 Mb al secondo per il 2007. Infatti, il Serial ATA attualmente disponibile è solo 17 Mb/s più veloce della comune interfaccia IDE, che raggiunge i 133 Mb/s (S-ATA 2.0 non è ancora diffuso).

Dal punto di vista tecnico, il più grande cambiamento è costituito dai cavi utilizzati. I dati viaggiano su un cavo flessibile con 7 contatti, le cui estremità sono larghe 8 millimetri, con i contatti disposti su due file. Rispetto ai corti (tra 45 e 90 cm) e larghi cavi da 40 o 80 contatti dell'interfaccia P-ATA, sono sicuramente più pratici. Inoltre, facilitano il passaggio dell'aria, rendendo più ordinato l'interno del case. Il concetto di master e slave, presente con i cavi P-ATA, è stato abolito a favore di un singolo cavo per hard disk. I contatti hanno una sagoma asimmetrica, in modo da non poterli inserire erroneamente in posizione errata.

Gli hard disk S-ATA prevedono un tipo di connettore di alimentazione diverso. Simile al cavo di trasmissione dei dati, è più largo ed è costituito da 15 conduttori, che trasportano le tre diverse tensioni di alimentazione necessarie: 3,3V, 5V e 12V.

Durante la transizione tra l'interfaccia IDE ed il S-ATA sono previsti diversi convertitori per rendere compatibili i due standard. Per quanto riguarda l'alimentazione, i cavi ad Y con connettori standard sono sostituiti dai cavi di alimentazione S-ATA, che hanno un connettore femmina standard e due connettori maschi S-ATA. Per quanto riguarda la conversione del trasporto dati, è necessario un ponte che converta la trasmissione di dati parallela in seriale e viceversa. Diversi produttori di hard disk hanno già a listino drive nativi S-ATA e la maggior parte dei nuovi modelli di schede madri supporta almeno due hard disk di questo tipo oltre ai due canali IDE, spesso sono supportate anche le diverse configurazioni RAID.

Le specifiche S-ATA prevedono la possibilità di inserimento hot (a caldo), cioè senza necessità di togliere l'alimentazione al personal computer, tuttavia alcuni controller non implementano questa funzione, spesso a causa di limitazioni presenti nel BIOS.

Per concluedere si piò dire che il futuro si muove verso il nuovo standard S-ATA e con gradualità le vecchie interfacce IDE sono destinate a svanire.

SETTORI E TRACCE NEL DISCO

I computer, in perfetta tradizione con la loro natura "binaria", elaborano, trasmettono e memorizzano dati sotto forma di un codice a due stati logici che, per comodità, siamo soliti indicare con le cifre 0 e 1. Tali cifre binarie, bit (binary digit), per usare un termine molto più familiare agli informatici, vengono memorizzati in un hard disk come carica magnetica positiva o negativa sul rivestimento di ossido dei piatti del disco. Il disco rigido è organizzato in un modo ben preciso: esiste una struttura abbastanza complessa e una serie di regole che, decidendo univocamente la posizione di salvataggio di ciascun file, impediscono l'effetto "di dispersione dei dati". Tale struttura "organizzativa" è chiamata formattazione e il registro di tutta la struttura, una sorta di "rubrica telefonica" dei file, si chiama File System.La formattazione dei dischi è in realtà duplice: fisica e logica.

Un disco fisso deve necessariamente essere formattato fisicamente prima di

poter essere formattato logicamente. Una formattazione fisica del disco fisso

(low level format) viene di solito eseguita dal produttore.

La formattazione a basso livello organizza i piatti del disco fisso negli

elementi fisici fondamentali: tracce, settori e cilindri. Le tracce sono

percorsi circolari rappresentabili con dei cerchi concentrici, presenti su ogni

faccia di ciascun piatto. Si è soliti individuare ciscuna traccia con un numero

a partire dalla traccia zero sita sul bordo esterno.

L'insieme di tracce che si trova alla stessa distanza dal centro (ovvero con lo stesso numero) su tutti i lati di tutti i piatti viene chiamato cilindro. Questo ulteriore raggruppamento non vuole solo rappresentare un'inutile complicazione mentale, bensì un comodo strumento, tant'è che molto spesso l'hardware e il software del computer fanno riferimento direttamente a questi ultimi.

Sottoinsiemi delle tracce sono invece i settori; queste aree sono utilizzate per memorizzare una quantità fissa di dati. I settori sono di solito formattati per contenere 512 byte di dati. I supporti magnetici, per quanto affidabili, non garantiscono a vita la permanenza delle informazioni memorizzate: in alcuni casi pertanto accade che la superficie si deteriori presentando settori danneggiati. Quando si verifica un problema del genere la miglior cosa da fare è effettuare un backup del contenuto e formattare a basso livello il disco rigido. Questa operazione, infatti, è in grado di ripristinare tali settori difettosi o di classificarli definitivamente come settori da non usare.

La formattazione fisica cancella definitivamente il contenuto del disco rigido e, seppure in casi estremamente rari, può rappresentare una pratica rischiosa per l'HD stesso. Per questa ragione, vi sconsigliamo di effettuare una formattazione a basso livello se non si è perfettamente in grado di capire quello che si sta facendo.

CD BOOTABLE

Un cd bootabile non è altro che un cd in cui è presente un boot record, ovvero un'area contenente le istruzioni per effettuare l'avvio, analogamente a quello che avviene nei floppy e nei dischi fissi; in questo boot record viene indicato se il cd deve emulare il comportamento di un floppy, oppure quello di un hard disk, e contiene indicazioni sulla dislocazione dell'immagine necessaria per l'avvio.Il cd bootabile sta di fatto rimpiazzando il glorioso floppy disk, scomparso nelle configurazioni dei pc più recenti.

I campi di utilizzo dei cd bootabili sono vari e molteplici, ma è quando siamo in difficoltà ad avviare il nostro pc che assumono davvero grande importanza. Un altro momento in cui avere un cd bootabile è davvero cosa graditissima è se dobbiamo installare sistemi operativi a partire da immagini, come nel caso di programmi come Symantec Ghost o Acronis True Image; in questo caso avere un cd bootabile è indispensable, tanto che tutti i programmi come i sopracitati hanno la possibilità di creare un cd bootabile.

Tutti i pc più recenti sono in grado di effettuare il boot da un cd, a condizione che questa opzione sia abilitata nel Bios; per i pc meno recenti (vecchi più di 5-6 anni), potrebbe essere ancora possibile avere questa opzione, magari effettuando un aggiornamento del bios, per cui consigliamo di visitare il sito del produttore della scheda madre, per conoscere se sono disponibili eventuali aggiornamenti del bios.

LA TECNOLOGIA RAID

La tecnologia RAID (Redundant Array of Independent Disks) permette, in modi differenti, di intervenire su ognuno di questi aspetti. Con il termine RAID si intende la configurazione di due o più hard disk, possibilmente identici quanto a capacità di memorizzazione e tecnologia, portati a lavorare in modo sincrono, cioè legato l'uno all'altro. Tale legame può essere di forme differenti, esemplificate dalle modalità di configurazione RAID disponibili:- RAID 0: nota anche come striping, è quella modalità che permette di "legare" tra di loro differenti dischi, facendoli vedere dal sistema come un'unica unità, anche se fisicamente composta da due o più dischi. Si tratta del processo inverso rispetto al partizionare in modo multiplo un'unità: mentre in quel caso si hanno differenti partizioni, quindi unità magnetiche, utilizzando una sola unità fisica, con lo striping si ottiene un'unica unità magnetica (anche se è sempre possibile crearne più di una, partizionando) congiungendo differenti unità fisiche. Il vantaggio del RAID 0 è quello di permettere un aumento delle capacità di memorizzazione, continuando a vedere i dispositivi di memorizzazione come un'unica unità magnetica (cosa impossibile da ottenersi affiancando due hard disk non in configurazione RAID). Utilizzando lo striping la capacità dei dischi utilizzati è sempre pari a quella del più piccolo; se, ad esempio, si connettessero in striping RAID 0 tre hard disk, rispettivamente da 30, 60 e 80 Gbytes, si otterrebbe un'unica unità di capacità pari a quella del disco da 30 Gb. Il vantaggio di questa configurazione consiste nel fatto che i trasferimenti in lettura sequenziale (sustained data transfers) sono effettuati in modo più performante rispetto alla configurazione non RAID. Secondo tipo di configurazione RAID 0 è quella spanning, con la quale viene utilizzata tutta la capacità dei dischi collegati, ma perdendo i vantaggi prestazionali nei trasferimenti in lettura sequenziale di dati propri della modalità striping.

- RAID 1: noto anche come mirroring, in questa modalità i dati vengono scritti su entrambi i dischi, così che uno sia copia speculare dell'altro; qualora dovesse esserci qualche problema e/o errore di scrittura-lettura, oppure perdita di dati, il sistema andrà a recuperare le informazioni sull'altro hard disk, così da garantire la continuità delle operazioni. Questa modalità massimizza la sicurezza dei dati, ma porta a una riduzione delle prestazioni (sono pari a quelle di un singolo disco connesso al controller) e allo spreco di spazio (se sono configurati in mirroring due hard disk da 80 Gbytes ciascuno, il sistema vedrà il tutto come un'unica unità magnetica da 80 Gbytes).

Con la modalità RAID 1, in caso di rottura di un disco è possibile, a sistema funzionante, provvedere alla sostituzione dell'hard disk danneggiato, senza perdita di dati e necessità di spegnere e/o riavviare il sistema; questa funzione, nota come swapping, permette di garantire continuità nel funzionamento, caratteristica apprezzata in particolari contesti quali quelli delle workstation, nei quali è importante che il sistema non si fermi.

- RAID 0+1: tale modalità unisce i vantaggi del mirroring con quelli dello striping; due hard disk sono connessi tra di loro in modalità striping, mentre altri due dischi ne formano il mirror. Questa soluzione permette di ottenere le elevate prestazioni proprie dello striping unitamente alla sicurezza per i dati propria della modalità mirroring.

- RAID 5: in questa configurazione due hard disk contengono i dati, mentre il controller calcola attraverso una specifica espressione matematica quella che è chiamata la copia di parity; quest'ultima contiene quelle informazioni necessarie a riscrivere le informazioni su uno dei due dischi qualora, per un qualsiasi motivo, dovessero essere danneggiate e/o perse. La copia di array viene distribuita su tutti i dischi che compongono la catena RAID.

HARD DISK ESTERNI E USB KEY

Esistono in commercio custodie delle dimensioni di un palmare che permettono di inserivi un disco rigido da PC portatile in modo da fungere da HD esterno con collegamento USB. Il contenitore che rende portatile il disco costa poche decine di euro mentre il costo del disco varia in funzione della capacità tenendo conto che questi HD sono in genere un pò più costosi di quelli usuali da 3.5" perché destinati ai PC portatili quindi miniaturizzati e realizzati per essere in grado di resistere agli urti accidentali. Questa soluzione è in genere conveniente quando si acquista un nuovo HD di capacità maggiore per il proprio PC portatile rendendo disponibile il vecchio HD che può essere sfruttato in questo modo al solo costo del contenitore. La stessa operazione con un contenitore specifico può essere effettuata con un disco rigido di dimensioni standard, magari sostituito in un desktop sacrificando ovviamente un pò le dimensioni che diventano simili a quelle di un libro e hanno bisogno di un alimentatore esterno (in genere non necessario per i mini HD da portatile). Esistono anche in commercio HD esterni già compresi di alimentatore e ottimizzati per una maggiore resistenza agli urti. La grande capacità dei dischi rigidi e la disponibilità eventuale (in caso di sostituzione nel portatile o nel desktop del disco rigido) rendono questa soluzione per certi versi accattivante ma in effetti risulta essere la meno portatile (soprattutto nel caso sia necessario un alimentatore) e in grado di generare numerosi problemi (necessità di alimentazione, volume eccessivo, sensibilità agli urti violenti, ecc.)Ormai la tecnologia si è diffusa rendendo disponibili mini HD delle dimensioni inferiori a quelle di un pacchetto di sigarette che sfruttano un collegamento USB di capacità variabile da 1 a qualche Gb. I vantaggi sono grande capacità, gli svantaggi sono la sensibilità agli urti e un consumo, l'alimentazione viene fornita dal PC ospite tramite la connessione USB, che può essere rilevante specie per un PC portatile che funziona lontano dalla rete elettrica. I costi sono in relazione alla capacità, alla tecnologia utilizzata e alla velocità di registrazione/lettura dei dati. Le chiavi USB o pendrive sono l'ulteriore evoluzione dei dischi removibili: sono ormai disponibili in formati molto numerosi da 16 Mb sino a qualche Gb con grande varietà di prezzi in genere comunque contenuti. Sono piccole, efficienti e autoinstallanti, derivano l'alimentazione dal PC ospite attraverso la connessione USB in modestissime quantità, possono essere attaccate al portachiavi, sono robuste e virtualmente insensibili a graffi e urti, dispongono di un led che ne visualizza il funzionamento (come quello degli HD) e a volte sono dotate di un microinterruttore per rendere i dati di sola lettura (utilissimo quando si opera su un computer sconosciuto o si opera il ripristino di un PC infetto). La scelta della dimensione della chiave dipende solo dall'utilizzo previsto e da quanto desideriamo spendere. In una chiavetta USB da 128 Mb si possono già inserire molti programmi e dati, ma conviene pensare ad un taglio di almeno 256/512 Mb e, se intendiamo farne un utilizzo frequente, anche a 1 Gb. In ogni caso sarà opportuno acquistare sempre una capacità doppia rispetto a quella che consideriamo la minima indispensabile per il nostro personale utilizzo, valutando attentamente il rapporto costo/Mb che in genere favorisce le dimensioni maggiori anche di molto e le offerte del momento: potrebbe essere addirittura economicamente conveniente acquistare due chiavi USB più piccole piuttosto che una sola grande. Le chiavi USP più futuristiche inoltre presentano anche funzioni ludiche, per l'ascolto di musica MP3, preventivamente scaricata e salvata sulla chiavetta, e l'ascolto della radio: in questi casi ovviamente la usk-key diventa più complessa e di maggiori dimensioni: presenta generalmente un piccolo display e dei tasti aggiuntivi, una uscita jack-stereo per l'audio e richiede una piccola batteria per il suo funzionamento (alloggiata internamente).

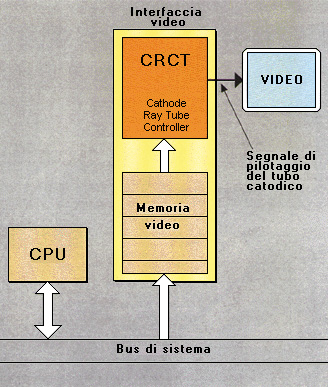

GLI ADATTATORI VIDEO

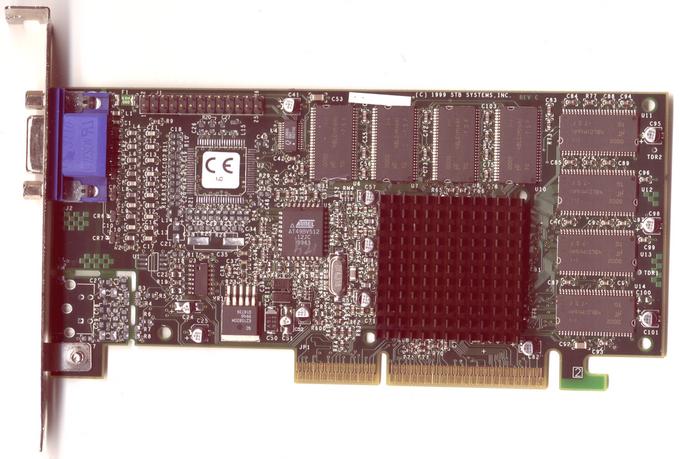

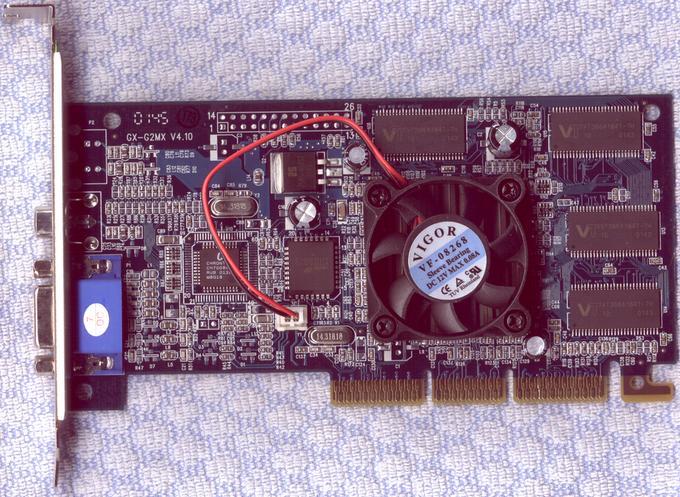

Il sistema video si compone di due parti: l'adattatore e il monitor. L'adattatore video o controller (chiamato anche scheda grafica) è il componente elettronico che crea l'immagine (il monitor la visualizza soltanto); può essere integrato nella scheda di sistema o essere una scheda con un circuito separato, inserita in uno slot; è dotato di un connettore esterno per collegare il monitor. Gli adattatori video più noti sono: - MDA (Monochrome Display Adapter) che permette di visualizzare solo testo (e non immagini grafiche); - HCG (Hercules Graphic Card) che permette di visualizzare anche grafici ma in un solo colore (noto anche come scheda per grafica monocromatica). - CGA (Color Graphic Adapter: Adattatore per Colore/Grafici) che permette una suddivisione dello schermo al massimo in 640 X 200 pixel. - EGA (Enhanced Graphic Adapter: Adattatore per Grafici Avanzati) che permette una suddivisione dello schermo al massimo in 640X350 pixel e l'uso di 16 colori scelti da una tavolozza di 64. - VGA (Video Graphic Adapter: Adattatore Video Integrato) che permette una suddivisione dello schermo fino a 640x480 o 800X600 pixel e l'uso di 256 colori; la risoluzione dipende però anche dalla memoria installata sulla scheda e dal tipo di monitor. - schede VGA avanzate, dette anche schede SVGA (Super VGA), che possono arrivare a una risoluzione di 1280X1024 pixel e permettere l'uso di milioni di colori, se dotate della memoria necessaria. Mancano ancora però degli standard validi per tutti, così i programmi utilizzati possono non riuscire a sfruttare al massimo una scheda dalle alte prestazioni. I fabbricanti hanno creato un comitato industriale che fissi gli standard (VESA - Video Electronics Standard Association). Ogni nuovo standard rappresenta un'evoluzione rispetto al precedente; migliora la qualità aumentando la risoluzione e/o i colori. I quattro standard VESA principali sono: risoluzione 640x480 con 256 colori; risoluzione 800x600 con 16 colori; risoluzione 800x600 con 256 colori; risoluzione 1024x768 con 16 colori.Scheda grafica AGP con ventola

MODALITA' PERMESSE DALL'ADATTATORE

L'adattatore video permette di utilizzare il video con modalità diverse, di testo e di grafica. La modalità-testo utilizza lo schermo con una suddivisione di 25 righe X 40 colonne o 25 righe X 80 colonne di caratteri. I caratteri sono visualizzati in caselle formate da pixel, tutte della stessa dimensione; la loro forma è registrata nella ROM; da qui viene letta e portata sullo schermo video. Le schede che rappresentano i caratteri con caselle più grandi (formate da più pixel) visualizzano caratteri migliori, più nitidi. I caratteri CGA sono rappresentati in caselle di 8x8 pixel; i caratteri EGA sono rappresentati in caselle 8x14; i caratteri VGA sono rappresentati in caselle 8x16 e risultano quindi più precisi, maggiormente particolareggiati. In modalità-grafica è possibile indirizzare i singoli pixel stabilendone le caratteristiche (colore, intensità ecc.). Ogni adattatore può arrivare a una certa risoluzione massima (orizzontale e verticale) e permette di selezionare il numero di pixel sullo schermo in modo da ottenere definizioni diverse dell'immagine. Ogni tipo di definizione permette di utilizzare particolari caratteristiche, per esempio quelle relative alle combinazioni di colori disponibili. La scheda VGA contiene una certa quantità di memoria video, in genere 256 o 512 Kbyte, in cui è contenuta l'immagine che appare sul video; dalla quantità di memoria installata sulla scheda video dipende la massima risoluzione raggiungibile e il numero di colori visualizzabili. Con 256 K di memoria è possibile utilizzare 16 colori a una risoluzione di 640x480 pixel, ma per poter usare 256 colori bisogna ridurre la risoluzione a 320x300 pixel. Avendo sulla scheda 512 K di memoria si potrebbero utilizzare 256 colori alla risoluzione di 640x480 pixel. Le schede grafiche possono essere dotate di acceleratori grafici per migliorare le prestazioni; l'efficienza varia in base al tipo di software utilizzato e ai relativi driver.LA SCHEDA VGA

Le modalità-video permesse dalla scheda VGA standard sono:+----------------------------------------------------------------+ ¦ modalità ¦ tipo ¦ risoluzione ¦ colori ¦ +-----------------+-----------+------------------+---------------¦ ¦ 0 e 1 ¦ testo ¦ 40x25 ¦ 16 ¦ ¦ 2 e 3 ¦ testo ¦ 80x25 ¦ 16 ¦ ¦ 4 e 5 ¦ grafica ¦ 320x200 ¦ 4 ¦ ¦ 6 ¦ grafica ¦ 640x200 ¦ 2 ¦ ¦ 7 ¦ testo ¦ 80x25 ¦ monocromatico ¦ ¦ D ¦ grafica ¦ 320x200 ¦ 16 ¦ ¦ E ¦ grafica ¦ 640x200 ¦ 16 ¦ ¦ F ¦ grafica ¦ 640x350 ¦ monocromatico ¦ ¦ 10 ¦ grafica ¦ 640x350 ¦ 16 ¦ ¦ 11 ¦ grafica ¦ 640x480 ¦ 2 ¦ ¦ 12 ¦ grafica ¦ 640x480 ¦ 16 ¦ ¦ 13 ¦ grafica ¦ 320x200 ¦ 256 ¦ +----------------------------------------------------------------+La modalità-grafica è definita come numero di pixel, la modalità testo come numero di caratteri.

GLI ACCELERATORI GRAFICI

Le applicazioni di grafica ad alta risoluzione possono richiedere molto tempo per ridisegnare lo schermo e la CPU rimane occupata a lungo soltanto per decidere l'aspetto dello schermo; i dati per la visualizzazione devono poi essere trasferiti tra la CPU e la scheda video attraverso il bus (in genere a 8 o 16 bit anche se il processore è a 32); la velocità di visualizzazione è quindi limitata dall'ampiezza del bus. Le schede più avanzate comprendono un coprocessore video o un acceleratore grafico; in questo modo gran parte dell'elaborazione dei dati per il video viene eseguita direttamente sulla scheda (per esempio la determinazione di quali pixel devono apparire e di quale colore). Dopo la diffusione dell'ambiente Windows (le applicazioni di Windows girano in modalità grafica), che ha portato alla richiesta di acceleratori grafici a basso costo da parte di molti utenti, si è affermato lo standard di accelerazione grafica 86C911 da S3 (S cubed) chiamato anche chip S3.IL MONITOR